Armando Caroli Consulente di Direzione Apco CMC, Fondatore di AAC Consulting, Formatore Qualificato A.I.F. Associazione Italiana Formatori, Proboviro Confindustria Assoconsult

Corre l’anno 1977 e la mia prima attività di sviluppo tecnico commerciale di una piccola impresa di informatica mi porta a contatto con i computer e con l’interazione che gli uomini hanno con essi.

In questo decennio, epoca di crescita industriale durante la quale l’aumento di produzione è strettamente correlato con l’aumento del numero di persone impiegate nell’attività, i computer sono di supporto esecutivo per i compiti amministrativi e per il calcolo dei fabbisogni di produzione e di magazzino. Qualcuno comincia ad elaborare i dati degli stipendi e dei salari.

I computer sono grandi armadi che consumano molto, sono fastidiosamente rumorosi, scaldano come delle stufe ed hanno necessità di 18°C per funzionare; il dialogo con loro è semplice: schede perforate in input e carta, tanta carta, in output…

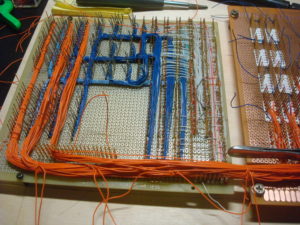

Questa impresa di informatica costruisce programmi per i clienti, ma ha anche accesso nello stesso piano al  Centro Elaborazione Dati, il CED, del produttore Honeywell, nel quale inseriamo dati, li elaboriamo e produciamo stampe con dati, tanti, tanti dati. I tecnici che hanno fatto la programmazione della CPU, la Central Process Unit, hanno usato la molto molto basica tecnica wire wrap che connette le varie parti del circuito di elaborazione con filo di rame avvolto attorno ai pioli, sempre di rame!

Centro Elaborazione Dati, il CED, del produttore Honeywell, nel quale inseriamo dati, li elaboriamo e produciamo stampe con dati, tanti, tanti dati. I tecnici che hanno fatto la programmazione della CPU, la Central Process Unit, hanno usato la molto molto basica tecnica wire wrap che connette le varie parti del circuito di elaborazione con filo di rame avvolto attorno ai pioli, sempre di rame!

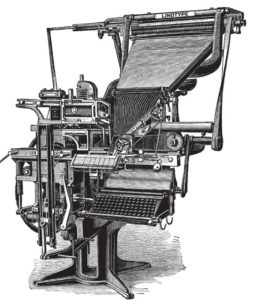

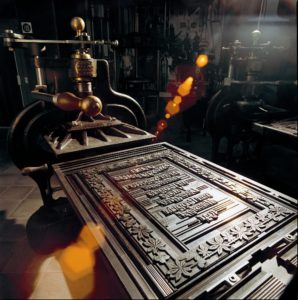

Nello stesso stabile al piano terreno c’è una tipografia, che stampa libri e collane per una casa editrice ecclesiastica, ed il processo di preparazione mi incuriosisce, perché ho visto le macchina da stampa, molto complesse, che praticamente usano lo stesso procedimento usato da Gutemberg: grandi lastre piane con i testi impaginati e sistemati in quartine che, inserite in una pressa, trasferiscono l’inchiostro sulla carta più e più volte. I caratteri del testo sono preparati tramite la fusione del piombo.

La mia curiosità per capire questo procedimento mi porta a visitare una vecchia stamperia dove scopro la nera  Linotype, capolavoro di ingegneria e di meccanica, e capisco che il piombo fuso “dal vivo” per costruire le righe di testo, carattere per carattere, non è proprio un toccasana per la salute. Il processo mi dicono che si chiama “composizione a caldo”.

Linotype, capolavoro di ingegneria e di meccanica, e capisco che il piombo fuso “dal vivo” per costruire le righe di testo, carattere per carattere, non è proprio un toccasana per la salute. Il processo mi dicono che si chiama “composizione a caldo”.

Il tempo passa e siamo nel 1982, conosco i nuovi mini computer con videoterminali, dischi rimovibili e nastri per l’archiviazione, il Personal Computer IBM, ed un amico mi parla della Fotocompositrice come il nuovo rivoluzionario sistema di inserimento caratteri nelle macchine da stampa, che si stanno a loro volta rivoluzionando in modo complementare diventando elettroniche.

Mi ricordo delle lastre con il piombo e chiedo maggiori spiegazioni, così scopro che sono state inventate e costruite macchine per inserire in modo digitale, tramite tastiera, i caratteri tradizionali e tutti i codici di controllo per la stampa. Il procedimento è stato battezzato “composizione a freddo”. Alcuni centri cominciano già ad inserire i dati per le enciclopedie, pur con non poche difficoltà, perché questo procedimento richiede molto tempo e lascia errori da correggere in gran numero.

Ho coscienza del progresso e dell’importanza delle evoluzioni tecnologiche e comincio ad orientare l’ascolto sulle notizie pertinenti a quest’area. Adoro i processi complessi, così inizio l’elaborazione di un segmento più ampio di attività che va oltre la sola ridigitazione dei testi stampati; ipotizzo così la possibilità di acquisirli in modo automatico tramite sistemi di lettura ottica, gli stessi che, al momento, sono usati per digitalizzare immagini. Ma pare non esistano. Internet non c’è, devono passare ancora nove anni per avere il World Wide Web!

Passa un mese e sento per radio che il Comune di Torino, per la prima volta in Italia, sta sperimentando un lettore ottico che riconosce i caratteri stampati per archiviare documenti e testi per la biblioteca. Evviva, ho una pista…

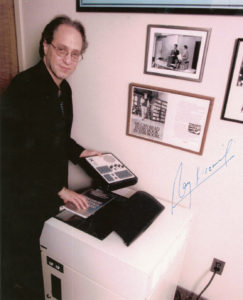

Dopo molti chilometri e un motore dell’auto fuso, arrivo alla determinazione tanto visionariamente teorizzata: in linea di massima si può fare! Si può gestire tutto il complesso processo che parte dall’acquisizione automatica di testi fino alla stampa su carta, o almeno la prima parte, quella dell’acquisizione. L ’apparecchiatura si chiama Kurzweil[1] 9000 ed è costruita dalla Kurzweil Computer Products, Inc., una piccola società partecipata dalla più grande Rank Xerox, la quale da qualche anno sta studiando l’avveniristico “ufficio senza carta” con il “Paperless Office Project”, ed il primo esemplare che vedo è grande quanto due lavatrici affiancate.

’apparecchiatura si chiama Kurzweil[1] 9000 ed è costruita dalla Kurzweil Computer Products, Inc., una piccola società partecipata dalla più grande Rank Xerox, la quale da qualche anno sta studiando l’avveniristico “ufficio senza carta” con il “Paperless Office Project”, ed il primo esemplare che vedo è grande quanto due lavatrici affiancate.

Ma quanto costa questo lettore! A Torino l’hanno pagato 210 milioni di lire: caspita, quanti testi si devono memorizzare per ammortizzarlo?

Fortunatamente esistono le leggi di mercato, e due mesi dopo inizia la trattativa con l’importatore ed arriviamo prima a 160 milioni e poi a 140 al momento della sottoscrizione del contratto sei mesi dopo. Anche la dimensione si è ridotta all’equivalente di una sola lavatrice. [FOTO]

Nella piena consapevolezza che sto per vendere al mercato nuovi e sconosciuti prodotti, mi metto a proporre il Servizio di Acquisizione dei Testi agli editori, dai piccoli ai grandissimi, scopro che il mercato c’è ed è di qualche miliardo di lire, però ci sono due imprevisti: gli appalti disponibili più importanti sono per opere molto complesse, con innumerevoli cambiamenti di fonti tipografiche ed abbreviazioni. Entrambe le cose sono assolutamente necessarie alle fotocomposizioni e la correzione del testo finale non deve lasciare errori, al massimo 3 ogni 100.000 caratteri per essere interessante! Che faccio, mi scoraggio? Un po’, certo, ma dura poco.

Curiosità, conoscenza e un pizzico di follia mi vengono in aiuto, così comincio, quasi “in garage”, un’avventura magica, che battezzo per i preventivi ai clienti con il nome di IOC, Input Ottico Computerizzato. Questo nuovo servizio che propongo agli editori ha la caratteristica di gestire il processo completo, dall’acquisizione dalla carta stampata al testo per la fotocomposizione, passando da un’elaborazione complessa che corregge i testi ed una normalizzazione per arrivare al formato di output richiesto. Peccato che non esista nulla del genere sul mercato ed anche con i primi ordini di libri di narrativa il problema si fa pressante e da risolvere!

Parte quindi la selezione di programmatori e ne trovo due validi, ai quali affido lo sviluppo del software per la correzione automatica, ed Andrea, con grande visione sistemica, arriva fino a definire una procedura di comprensione degli errori nei caratteri mal stampati tramite tabelle e sostituzione opportuna nel contesto della parola o della frase (sostituzioni singole o multiple 1 à n, 1 à 1, n à 1, n à n).

Si, perché nelle prime fasi di acquisizione, gli operatori hanno segnalato che le pagine non sono stampate in modo omogeneo come inchiostratura, in particolar modo le enciclopedie ed i dizionari. Come mai? Indago, ne va dell’esattezza dei risultati e del rispetto degli accordi contrattuali con gli editori…

Con l’analisi delle pagine acquisite dallo scanner Kurzweil e dei file memorizzati capisco subito: il piombo non va d’accordo con le modifiche temporalmente successive, cioè l’aggiornamento variato di una voce nelle enciclopedie o di un lemma nei dizionari obbliga la stamperia a preparare un solo nuovo “blocchetto” di testo che sostituisce pari pari il vecchio, per evitare di rifare tutta la lastra, che costerebbe molto.

Il piombo nuovo ha maggiore spessore rispetto al resto della lastra che si è consumata in modo progressivo ad ogni passaggio di trasferimento dell’inchiostro sulla carta ed in stampa questo viene perfetto e nitido, molto meglio del resto della pagina, più sfocata.

Il lettore ottico è bravo, riconoscendo anche i cambi di corpo e i tipi modificati come corsivo e grassetto, ma quando cambia la nitidezza dell’inchiostro, purtroppo sbaglia, così i programmi della Procedura IOC correggono. In questo modo parole come “inibuto” e “aiiiniraglio” tornano ad essere “imbuto” e “ammiraglio” e verifico che il dizionario di appoggio per la correzione automatica sta aumentando a qualche migliaio di parole.

Il processo IOC comincia ad avere una struttura formata da una squadra, con chi prepara le pagine per il lettore, chi effettua la lettura ottica e trasferisce i file sul Personal Computer IBM e poi sul Sistema 34 IBM, chi controlla le bozze e chi trasferisce i file sul supporto magnetico richiesto dal cliente per le fasi successive di elaborazione.

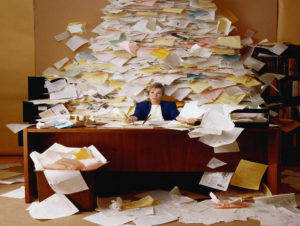

I risultati sono abbastanza vicini alla correzione richiesta, ma non ancora come quella concordata con i clienti, così purtroppo la rilettura a campione viene comunque effettuata nei file, esattamente come nel processo standard di digitazione. Il tempo disponibile nella giornata lavorativa non c’è, quindi usiamo la notte e i giorni festivi per recuperare. Questa fase viene tipicamente chiamata di “correzione di bozze” e richiede una particolare capacità di concentrazione: scopriamo che la maggior parte delle volte gli errori si annidano vicini, ed una distrazione può lasciare quattro o cinque refusi in un paio di periodi, inficiando il lavoro precedente e successivo.

All’epoca delle lastre di piombo i Correttori di Bozze sono numerosissimi, molto ricercati dagli editori ed i più bravi anche molto costosi.

Così i programmatori affinano i sistemi di correzione e conversione finale, gli operatori al Kurzweil 9000 pongono maggiore attenzione nella fase di memorizzazione ed i risultati non tardano: da 1 a 4 caratteri errati ogni 100.000 caratteri, compresi i cambi di corpo e i tipi modificati.

Il primo vero test lo facciamo con uno dei più conosciuti dizionari della lingua italiana, lo Zingarelli, e riusciamo a garantirne l’esattezza prevista, così si aprono fiduciariamente le porte di altri lavori con tutti i più importanti editori italiani.

Lavoriamo in più turni sull’unico lettore ottico e scopriamo la problematica del “collo di bottiglia”: non riusciamo ad aumentare la produzione perché con un utilizzo intensivo della macchina questa tende a rompersi ed il fermo macchina abbassa drammaticamente il risultato produttivo ed aumenta i costi di gestione per la sostituzione di parti meccaniche ed elettroniche. Arriviamo alla consapevolezza che i lettori ottici dovrebbero essere più di uno e che i sistemi di elaborazione dovrebbero essere più efficienti, così inizia una fase di sviluppo tecnologico che porta anche all’inserimento di cinque Personal Computer “compatibili IBM”, di un’unità a nastro magnetico, di una potente fotocopiatrice Xerox, di varie taglierine e la progressiva dismissione del vecchio Sistema 34 IBM.

Programmiamo anche l’acquisto di un secondo Kurzweil 9000 identico al primo per uscire dal collo di bottiglia, e  riusciamo a garantirci, così, anche l’interscambiabilità delle componenti meccaniche ed elettroniche. Siamo nel 1984 ed è passata la voce tra gli editori che a Bologna c’è una società esperta del processo completo chiamato Input Ottico Computerizzato e che ha già prodotto un’intera enciclopedia elettronica, così le commesse aumentano oltre ogni possibilità esecutiva. Facciamo anche un test di acquisizione dell’enciclopedia che vanta il primato di essere la più completa in Europa, che risulta essere positivo, così col contratto firmato in mano, decidiamo di acquisire anche un terzo lettore ottico e di programmare il lavoro su tre turni.

riusciamo a garantirci, così, anche l’interscambiabilità delle componenti meccaniche ed elettroniche. Siamo nel 1984 ed è passata la voce tra gli editori che a Bologna c’è una società esperta del processo completo chiamato Input Ottico Computerizzato e che ha già prodotto un’intera enciclopedia elettronica, così le commesse aumentano oltre ogni possibilità esecutiva. Facciamo anche un test di acquisizione dell’enciclopedia che vanta il primato di essere la più completa in Europa, che risulta essere positivo, così col contratto firmato in mano, decidiamo di acquisire anche un terzo lettore ottico e di programmare il lavoro su tre turni.

Sembra di essere in fabbrica: un gruppo di lavoro prepara le pagine per la scansione ottica, alcuni operatori acquisiscono i testi stampati, altri li convertono in byte e li spediscono in modo cadenzato ai PC collegati in rete locale, altri operatori controllano le tabelle di sostituzione ed il dizionario di riscontro per il testo ed una persona è responsabile dell’ultima conversione verso il nastro magnetico.

Tutto sembra filare liscio, fino quando Murphy, con le sue leggi sui paradossi, non decide di metterci lo zampino!

Il primo blocco della Grande Enciclopedia è pronto ed è stata lanciata l’ultima impegnativa elaborazione prima di preparare il nastro magnetico; l’ingegnere romano che deve portarlo a Tokio alla Sony, dove c’è la prima “camera bianca” per la produzione di master per CD-ROM, è in sala d’aspetto ed ha il volo a Milano prenotato fra sei ore. L’elaborazione termina a mezzanotte, così ci accingiamo con allegria a salvare i dati e a festeggiare, inseriamo il nastro magnetico nell’unità e al caricamento immediatamente questa si blocca con un rumore sordo di parti  metalliche: unità rotta!

metalliche: unità rotta!

Alle due della mattina dobbiamo arrenderci all’evidenza, la periferica è guasta irrimediabilmente ed il nastro per Tokio non riusciamo a prepararlo…un dramma. A Tokio non aspettano, sono molto pragmatici i giapponesi ed hanno le masterizzazioni pianificate per mesi.

Ci vogliono due giorni interi per trovare in una struttura ospedaliera un’unità simile e terminare finalmente il passaggio, ma ce la facciamo. L’ingegnere parte col suo prezioso carico per Tokio, sapendo che è stato necessario pregare molto i responsabili della Sony per avere una seconda sessione di masterizzazione e che non possono esserci errori di alcun genere nei file.

Dopo una settimana di trepidazione, l’ingegnere ci comunica che il processo è andato benissimo e possiamo procedere con il resto dei venti volumi e poi con altri venti delle Leggi d’Italia.

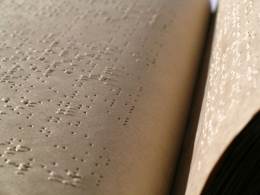

L’informazione di questo successo è arrivata anche a Monza, dove un illuminato direttore della Biblioteca Italiana per Ciechi ci chiede di adattare tutto il processo di acquisizione testi ad un output su punzonatrice Braille a matrice metallica fronte-retro. Due mesi di tempo per adattare il software alle caratteristiche del Braille e stampiamo il primo libro per non vedenti; il gruppo di lavoro riceve un riconoscimento per questa attività ed in regalo il primo libro che ha una copertina nera, come i quaderni del dopoguerra: ci sentiamo veramente sinceramente orgogliosi come non mai per quanto realizzato.

Dopo sei anni dall’inizio dell’avventura, siamo nel 1988, abbiamo memorizzato tutte le più importanti opere del mercato editoriale italiano e sono nati i primi CD-ROM, poi diventati DVD, con sistemi di ricerca testuale indicizzata di tipo Information Retrieval, prima di arrivare ai più moderni Ipertesti; abbiamo archiviato e preparato per milioni di utenti le prime basi di dati italiane ed un calcolo complessivo indica che abbia superato la cifra di 3,5 Gigabyte di caratteri stampati su carta che sono diventati caratteri digitali.

Nel frattempo il progetto Xerox dell’ufficio senza carta è stato sospeso, i Personal Computer sono diventati molto più potenti dei primi, i grandi mainframe sono stati sostituiti da unità di processo molto più piccole e connesse, la navigazione sugli schermi dei computer è passata dall’interfaccia carattere a Windows, presentato da Microsoft su licenza Apple, sono scomparse le fotocompositrici e gli scanner con un software di riconoscimento caratteri sono diventati poco più grandi di un foglio A4 e costano pochissimo.

E di una cosa pressoché nessuno si è accorto: non esistono più le grandi lastre con le quattro pagine ed i caratteri in piombo per la stampa a pressione. Che cosa meravigliosa è il Progresso!

Armando Caroli

Riconoscimenti:

-

Al prof. Giovanni Degli Antoni, mancato il 9 aprile 2016, in quegli anni Direttore del Dipartimento di Scienze dell’Informazione dell’Università degli Studi di Milano per l’incredibile impulso dato verso la digitalizzazione nazionale;

-

al rag. Andrea Treggia, per lo sviluppo del software che è stato colonna portante del servizio I.O.C.

-

al dott. Andrea Boroli, in quegli anni Amministratore Delegato dell’Istituto Geografico De Agostini di Novara, per aver creduto nel servizio I.O.C. firmando i contratti più importanti per la digitalizzazione delle opere per la De Agostini;

-

all’ing. Guido Bucciotti, in quegli anni capo progetto per conto dell’Istituto Geografico De Agostini di Novara, che ha coordinato con noi tutte le fasi del processo, dall’acquisizione alla costruzione delle basi dati digitali, permettendo l’incredibile sviluppo della Casa Editrice ed il suo successo negli anni a venire;

-

all’ing. Mario Taccini, in quegli anni responsabile incaricato della produzione del MASTER CD-ROM a Tokyo, per aver gestito la situazione ad alta problematica creata dal guasto della periferica a nastro evitando un disastro del progetto;

al prof. Rodolfo Cattani, in quegli anni Direttore della Biblioteca per Ciechi di Monza e oggi Presidente della commissione di collegamento UE – European Blind Union (EBU), per aver pensato di automatizzare tramite i programmi del servizio I.O.C. la produzione di libri Braille stampati in fronte-retro con lo scopo di moltiplicare il numero di libri disponibili in Italia per i non vedenti

image @pixabay.725148-joseavi1974

[1] Il CEO di questa società è Raymond Kurzweil (New York, 12 febbraio 1948) che è inventore, informatico e saggista statunitense di origine austriaca. È un pioniere nei campi del riconoscimento ottico dei caratteri, nel text-to-speech per non vedenti, nelle tecnologie sul riconoscimento del parlato e degli strumenti da tastiera elettronici. È autore di numerosi libri sulla salute, l’intelligenza artificiale, il transumanesimo e la singolarità tecnologica. Detiene il primato di essere uno degli inventori con più brevetti al mondo. Nel 2007 ho avuto la possibilità di ascoltare un suo speech in un evento a Milano.